สวัสดีครับ สำหรับโพสต์นี้เรามาต่อกันในตอนที่ 3 ซึ่งเป็นแก่นสำคัญของ AI Auditing Framework เนื้อหาค่อนข้างยาวและมีหลายประเด็นสำคัญ ดังนั้นผมจะแบ่งออกเป็น 2 ตอนย่อย เพื่อให้ผู้อ่านสามารถติดตามและทำความเข้าใจได้อย่างลึกซึ้งนะครับ

ตอนที่ 3: กรอบการตรวจสอบ AI: การกำกับดูแลและการจัดการ (ตอนที่ 1)

The IIA’s AI Auditing Framework ฉบับแรกได้เผยแพร่ในปี 2017 โดยมีจุดประสงค์เพื่อให้ผู้ตรวจสอบภายในมีแนวทางในการให้บริการที่ปรึกษาและให้ความเชื่อมั่นด้าน AI อย่างเป็นระบบและมีระเบียบวินัย ส่วนฉบับปรับปรุงนี้ได้นำเสนอเนื้อหาที่ทันสมัยยิ่งขึ้น พร้อมตัวอย่างจากสภาพแวดล้อม AI ในปัจจุบัน และให้รายละเอียดเพิ่มเติมเพื่อช่วยผู้ตรวจสอบภายในทั้งในบทบาทที่ปรึกษาและผู้ให้ความเชื่อมั่น

กรอบการทำงานนี้มี 3 ส่วนหลัก (Domains):

- การกำกับดูแล (Governance)

- การจัดการ (Management)

- การตรวจสอบภายใน (Internal Audit)

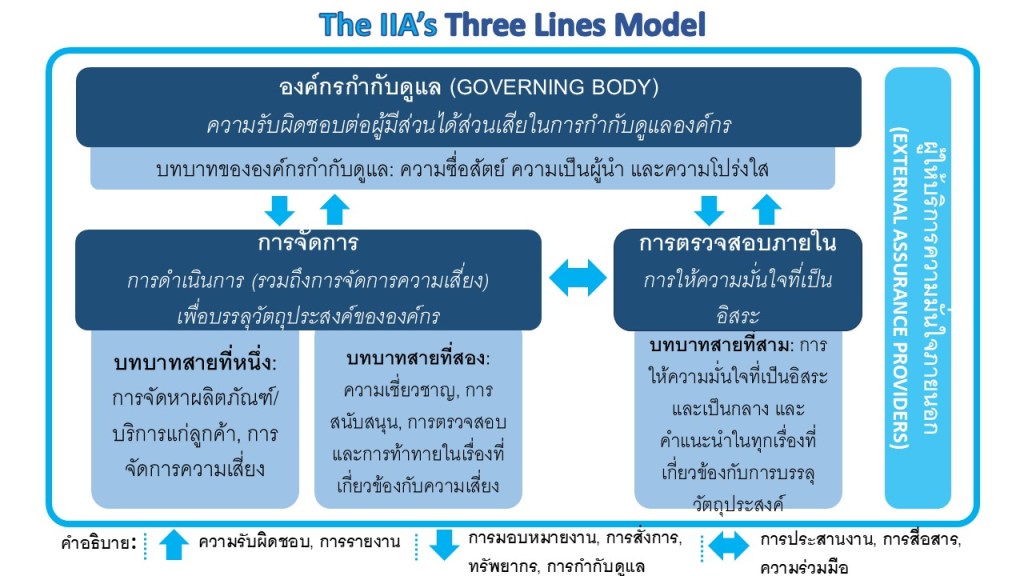

กรอบการทำงานนี้เชื่อมโยงกับ The IIA’s Three Lines Model โดยที่ องค์กรที่กำกับดูแล (Governing Body) (Governance) จะกำกับดูแล ฝ่ายบริหาร (Management) (First and Second Lines) ในขณะที่บทบาทของ การตรวจสอบภายใน (Internal Audit) จะครอบคลุมอยู่ในส่วนที่สาม ซึ่งรวมถึงทั้งการให้ความเชื่อมั่นที่เป็นอิสระ (Third Line) และกิจกรรมการให้คำปรึกษา

วัตถุประสงค์หลักของกรอบการทำงานนี้คือการเสริมสร้างความรู้พื้นฐานที่จำเป็นเกี่ยวกับ AI ให้แก่ผู้ตรวจสอบภายใน เพื่อให้สามารถรับใช้องค์กรได้ใน 2 บทบาท:

- ที่ปรึกษา: ให้คำปรึกษาแก่ฝ่ายบริหารเกี่ยวกับแนวทางโดยรวมในการจัดการ, ดำเนินการ และติดตาม AI

- ผู้ให้ความเชื่อมั่น: ตรวจสอบกระบวนการและการควบคุมที่ฝ่ายบริหารได้จัดตั้งขึ้นเพื่อจัดการ, ดำเนินการ และติดตาม AI

ระดับความพร้อมขององค์กรในการนำ AI มาใช้งาน (Organizational maturity of AI) จะมีผลต่อการใช้งานผู้ตรวจสอบภายใน ตัวอย่างเช่น องค์กรที่ยังไม่พร้อมด้าน AI อาจต้องการให้ผู้ตรวจสอบภายในทำหน้าที่เป็นที่ปรึกษาในขั้นตอนการสำรวจ AI ในช่วงแรก ในขณะที่องค์กรที่มีความพร้อมมากกว่า มักจะใช้ผู้ตรวจสอบภายในเพื่อจัดกิจกรรมการให้ความเชื่อมั่น เช่น การประเมินประสิทธิภาพของกระบวนการและการควบคุมภายในที่จัดตั้งขึ้น เพื่อให้ปฏิบัติหน้าที่ทั้งสองได้สำเร็จ ผู้ตรวจสอบภายในจำเป็นต้องมีความเข้าใจอย่างถ่องแท้ว่า ควรจัดการ AI อย่างไร และองค์กรกำลังจัดการอยู่แล้วอย่างไร

ส่วนที่ 1: การกำกับดูแล (Governance)

การกำกับดูแล AI หมายถึงโครงสร้าง, กระบวนการ, และขั้นตอนการปฏิบัติงานที่ถูกนำมาใช้เพื่อชี้นำ, จัดการ, และติดตามกิจกรรม AI ขององค์กร รวมถึงการช่วยให้แน่ใจว่ากิจกรรม, การตัดสินใจ และการดำเนินการด้าน AI สอดคล้องกับค่านิยมขององค์กร รวมถึงความรับผิดชอบทางจริยธรรม, สังคม และกฎหมาย นอกจากนี้ยังรวมถึงการกำกับดูแลเพื่อให้แน่ใจว่าพนักงานที่มีหน้าที่รับผิดชอบด้าน AI มีทักษะและความเชี่ยวชาญที่จำเป็น

ดังที่สะท้อนใน Three Lines Model การตรวจสอบภายในทำหน้าที่เป็น “Third Line” โดยให้ความเชื่อมั่นที่เป็นอิสระและเป็นกลางต่อความถูกต้องของการควบคุมภายในที่องค์กรใช้ในการจัดการความเสี่ยง รวมถึงทุกแง่มุมของ AI ผู้ตรวจสอบภายในสามารถให้บริการที่ปรึกษาด้าน AI แก่องค์กรได้ แต่จากมุมมองด้านการกำกับดูแลแล้ว คณะกรรมการกำกับดูแลจะพึ่งพากิจกรรมการให้ความเชื่อมั่นที่จัดทำโดยการตรวจสอบภายในเป็นอย่างมาก เพื่อทำความเข้าใจประสิทธิภาพการดำเนินงานขององค์กรได้ดียิ่งขึ้น

การกำกับดูแล AI เป็นสิ่งสำคัญอย่างยิ่ง สองบทบาทที่สำคัญที่สุดของการกำกับดูแลคือการประเมินว่าองค์กรจัดการการดำเนินงานด้าน AI ได้ดีเพียงใด และเป้าหมายและวัตถุประสงค์เชิงกลยุทธ์ของ AI ขององค์กรบรรลุผลในลักษณะที่สอดคล้องกับค่านิยมที่กำหนดไว้หรือไม่ แม้จะมีความเสี่ยงเฉพาะทางด้าน AI จำนวนมากตามที่ได้นำเสนอไปในส่วนก่อนหน้า แต่ข้อพิจารณาหลักประการหนึ่งคือการกำกับดูแลเพื่อให้แน่ใจว่า AI ถูกนำไปใช้ในลักษณะที่จะไม่ก่อให้เกิดอันตราย

กลยุทธ์ (Strategy)

แผนกลยุทธ์ช่วยให้องค์กรชี้แจงและสื่อสารทิศทางและวิสัยทัศน์ที่จำเป็นต่อการบรรลุเป้าหมาย เช่นเดียวกับกลยุทธ์ AI กลยุทธ์ AI ของแต่ละองค์กรควรมีความเป็นเอกลักษณ์ โดยพิจารณาจากแนวทางในการใช้ประโยชน์จากโอกาสที่ AI มอบให้ พร้อมทั้งคำนึงถึงสถานการณ์เฉพาะขององค์กร เช่น รายละเอียดของบริการเทคโนโลยีในปัจจุบัน หรือโครงการริเริ่มการกำกับดูแลข้อมูลที่กำลังดำเนินอยู่ แนวทางการวางแผนกลยุทธ์ AI ที่รอบคอบและเป็นระบบจะช่วยสนับสนุนความสามารถขององค์กรในการมุ่งเน้นทรัพยากร และส่งเสริมการทำงานร่วมกันในหมู่พนักงานทุกคนพร้อมทั้งลดความเสี่ยงที่อาจเกิดขึ้น

ข้อควรจำที่สำคัญ 2 ประการ:

- การวางแผนกลยุทธ์ AI ไม่ใช่เหตุการณ์ที่เกิดขึ้นครั้งเดียว แต่เป็นกระบวนการซ้ำไปซ้ำมาที่ควรดำเนินการเป็นระยะ ผู้ตรวจสอบภายในควรทำงานร่วมกับฝ่ายบริหารเพื่อกำหนดตารางเวลาสำหรับการทบทวนกลยุทธ์ AI

- กลยุทธ์ AI ไม่ควรวางแผนอย่างโดดเดี่ยว เมื่อพิจารณาจากแหล่งข้อมูลและกรณีการใช้งานที่หลากหลาย กลยุทธ์ AI ขององค์กรควรเป็นแบบข้ามสายงาน (Cross-functional) ด้วยความสำคัญที่เพิ่มขึ้นของ AI การมีส่วนร่วมและการกำกับดูแลในระดับคณะกรรมการจึงน่าจะเกิดขึ้น เนื่องจาก AI มีศักยภาพที่จะเปลี่ยนแปลงหรือปรับเปลี่ยนกลยุทธ์ทางธุรกิจได้อย่างมาก

การจัดการกับประเด็นเหล่านี้จะช่วยให้แน่ใจว่าโครงการริเริ่มด้าน AI สนับสนุนวัตถุประสงค์โดยรวมขององค์กร และสอดคล้องกับค่านิยมที่ระบุไว้ การกำหนดเป้าหมายสำหรับ AI ช่วยให้องค์กรสามารถกำหนดข้อพิจารณาเชิงกลยุทธ์ที่สำคัญ รวมถึงคำตอบสำหรับคำถามพื้นฐาน เช่น “ทำไมเราถึงใช้ AI?” และ “เรากำลังพยายามบรรลุอะไร?” เป้าหมายของ AI ควรได้รับการพัฒนาเหมือนกับเป้าหมาย “SMART” อื่น ๆ ขององค์กร ได้แก่ Specific (จำเพาะเจาะจง), Measurable (วัดผลได้), Achievable (บรรลุผลได้), Relevant (เกี่ยวข้อง), และ Time-based (มีกรอบเวลา) เพื่อหลีกเลี่ยงการนำเครื่องมือและบริการ AI มาใช้โดยไม่มีขอบเขตที่ชัดเจนว่าองค์กรใช้ไปเพื่อเหตุผลใด

ทัศนคติและแนวทางโดยรวมขององค์กรต่อความเสี่ยงและการจัดการความเสี่ยงควรเป็นข้อพิจารณาหลักในการพัฒนาหรือปรับปรุงแผนและเป้าหมายเชิงกลยุทธ์ของ AI การมีทัศนคติที่ยอมรับความเสี่ยงที่สูงขึ้นในการบรรลุเป้าหมาย AI อาจไม่เหมาะสมสำหรับองค์กรที่ไม่ยอมรับความเสี่ยงในด้านอื่น ๆ ในขณะที่องค์กรที่มีความอดทนต่อความเสี่ยงสูงในอดีตอาจเต็มใจที่จะยอมรับความเสี่ยงที่เกี่ยวข้องกับ AI มากขึ้น อย่างไรก็ตาม ไม่ว่าองค์กรจะมีความอดทนต่อความเสี่ยงในระดับใด การรับรู้และจัดทำแผนที่ความเสี่ยง AI ระหว่างการวางแผนเชิงกลยุทธ์ด้าน AI ก็เป็นสิ่งจำเป็น

การจัดการ (Management) – First and Second Lines

ในการพัฒนากลยุทธ์ AI ฝ่ายบริหารมีหน้าที่รับผิดชอบในการตรวจสอบให้แน่ใจว่า การควบคุมภายในได้รับการออกแบบอย่างเหมาะสม และทำงานได้อย่างมีประสิทธิภาพเพื่อลดความเสี่ยง การควบคุมภายในที่มีประสิทธิภาพถือเป็นข้อกำหนดที่สำคัญของ AI ซึ่งหลายองค์กรมีการทดสอบและรายงานผลการควบคุมด้านไอทีเป็นรายไตรมาส และ/หรือรายปี ฝ่ายบริหารควรตระหนักถึงปัญหาการควบคุมภายในที่อาจส่งผลกระทบต่อการใช้ AI โดยเฉพาะอย่างยิ่งในพื้นที่ของสภาพแวดล้อมการควบคุมภายในที่ได้รับการประเมินอยู่แล้ว เช่น:

- ความสมบูรณ์ของการจัดการข้อมูล (Data Integrity and Data Governance)

- การเข้าถึงของผู้ใช้งาน (User Access)

- ความมั่นคงปลอดภัยทางไซเบอร์ (Cybersecurity)

- วงจรการพัฒนาระบบ (System Development Life Cycle)

- การจัดการการเปลี่ยนแปลง (Change Management)

- การควบคุมการสำรองข้อมูล/การกู้คืนข้อมูล (Back-up/Recovery Controls)

COBIT และ COSO เป็นตัวอย่างของกรอบการควบคุมภายในที่องค์กรสามารถใช้เพื่อช่วยในการวางแนวทาง และประเมินสภาพแวดล้อมการควบคุมภายในได้

การจัดการระดับ First Line

ภาวะผู้นำ การกำหนดบทบาทและหน้าที่ความรับผิดชอบที่เกี่ยวข้องกับโครงการริเริ่มด้าน AI จะช่วยให้องค์กรสามารถกำหนดทรัพยากรที่จำเป็นต่อการดำเนินงานได้อย่างมีประสิทธิภาพ การระบุผู้บริหารระดับสูงที่เป็นเจ้าของโครงการ พร้อมทั้งรับฟังความคิดเห็นจากสมาชิกคนอื่น ๆ ในกลุ่ม C-suite จะช่วยให้แน่ใจว่ามีการรับผิดชอบ

การจัดตั้ง ทีมผู้นำ AI (AI Leadership Team) ซึ่งประกอบด้วยสมาชิกจากหลากหลายสายงาน เป็นอีกวิธีที่องค์กรสามารถใช้เพื่อติดตามและสื่อสารโครงการริเริ่มด้าน AI และสนับสนุนความรับผิดชอบได้ ทีมดังกล่าวควรประกอบด้วย:

- ผู้จัดการด้าน AI และ/หรือวิทยาศาสตร์ข้อมูล

- CISO ขององค์กร

- บุคลากรไอทีที่สำคัญ

- ฝ่ายกฎหมาย (เพื่อให้คำแนะนำเกี่ยวกับข้อพิจารณาด้านกฎระเบียบ)

- ฝ่ายการเงิน/บัญชีเพื่อติดตามต้นทุนและผลตอบแทนจากการลงทุนของโครงการ AI

- การบริหารความเสี่ยง

- การปฏิบัติตามกฎระเบียบ

การตรวจสอบภายใน ซึ่งมีความรู้ที่กว้างขวางเกี่ยวกับองค์กร อยู่ในตำแหน่งที่เหมาะสมอย่างยิ่งที่จะทำหน้าที่เป็นที่ปรึกษาเพื่อสนับสนุนโครงการริเริ่มด้าน AI และควรได้รับการพิจารณาให้เป็นสมาชิกของทีมผู้นำ AI ด้วย อย่างไรก็ตาม การมีส่วนร่วมของการตรวจสอบภายในควรมีโครงสร้างที่ชัดเจนเพื่อให้แน่ใจว่าความเป็นอิสระในฐานะผู้ให้ความเชื่อมั่นจะไม่ถูกกระทบ

กระบวนการวางแผนที่รอบคอบจะช่วยสนับสนุนองค์กรเมื่อดำเนินโครงการ AI พนักงานที่เกี่ยวข้องกับการดำเนินโครงการจำเป็นต้องตระหนักถึงความเสี่ยงที่สำคัญที่สุด รวมถึงผลลัพธ์ที่ไม่พึงประสงค์ การเน้นย้ำและทำให้แน่ใจว่าการดำเนินโครงการในแต่ละวันมีความตระหนักรู้เกี่ยวกับแง่มุมทางสังคม, จริยธรรม, สิ่งแวดล้อม และเศรษฐกิจเป็นสิ่งสำคัญ นอกจากนี้ การส่งเสริมสภาพแวดล้อมที่กระตุ้นให้พนักงานเปิดเผยหารือเกี่ยวกับความคิดเห็นและข้อกังวลที่เกี่ยวข้องกับโครงการริเริ่มด้าน AI สามารถช่วยสร้างวัฒนธรรมของความโปร่งใส, การตระหนักรู้ และความรับผิดชอบร่วมกันเพื่อสนับสนุนโครงการ AI ที่มีความทะเยอทะยานได้

นโยบายและขั้นตอนการปฏิบัติงาน – การใช้งานภายในและแอปพลิเคชันทางธุรกิจ

การกำหนด, การนำมาใช้ และการเผยแพร่นโยบายและขั้นตอนการปฏิบัติงานขององค์กรที่เข้มงวดเกี่ยวกับการใช้ AI ภายในองค์กร เป็นอีกแง่มุมที่สำคัญของกลยุทธ์ AI ขององค์กร นโยบายและขั้นตอนการปฏิบัติงานที่ชัดเจนให้แนวทางแก่พนักงานที่เกี่ยวข้องโดยตรงกับโครงการริเริ่มด้าน AI และพนักงานที่อาจใช้ AI เป็นส่วนหนึ่งของความรับผิดชอบในงานประจำวัน

การพัฒนานโยบายการใช้งาน AI ที่ยอมรับได้ (AI acceptable use policy) ควรเป็นลำดับความสำคัญสูงสุดขององค์กร ควรครอบคลุมแง่มุมของแนวทางปฏิบัติที่ดีที่สุดด้านความมั่นคงทางไซเบอร์, ทรัพย์สินทางปัญญา/ข้อพิจารณาทางกฎหมาย และความเสี่ยงที่เกี่ยวข้องกับเครื่องมือ AI ต่าง ๆ นโยบายควรได้รับการเสริมด้วยกระบวนการที่มีการบันทึกไว้ซึ่งผู้ใช้ต้องปฏิบัติตามเมื่อร้องขอการใช้ AI การใช้กระบวนการอนุมัติที่เป็นทางการสำหรับการใช้ AI จะช่วยสนับสนุนความพยายามขององค์กรในการรักษารายการข้อมูลของผู้ใช้หรือแผนกที่ใช้ AI ด้วย

นโยบายและขั้นตอนการปฏิบัติงานที่ชี้แจงแนวทางและข้อคาดหวังที่ใช้ในการพัฒนา, การนำไปใช้งาน และการติดตามโครงการริเริ่มด้าน AI จะทำให้กระบวนการเป็นทางการมากขึ้น พวกเขาให้พื้นฐานในการตรวจสอบว่า โครงการถูกดำเนินการในลักษณะที่สอดคล้องกับนโยบายที่ได้รับอนุมัติ, จริยธรรม และวัฒนธรรมความเสี่ยงโดยรวมขององค์กรหรือไม่ ผู้ตรวจสอบภายในอยู่ในตำแหน่งที่เหมาะสมอย่างยิ่งที่จะให้ข้อเสนอแนะในทันทีเกี่ยวกับเรื่องนี้ เนื่องจากมีความรู้และประสบการณ์ในการให้ความเชื่อมั่นในเรื่องนโยบายและขั้นตอนการปฏิบัติงานที่สำคัญ ในหลายกรณี นโยบายและขั้นตอนการปฏิบัติงานที่มีอยู่แล้ว อาจเป็นจุดเริ่มต้นในการใช้มาตรการที่มีประสิทธิผลพอสมควร เพื่อลดความเสี่ยงที่เกิดจากการพัฒนา AI ตัวอย่างเช่น ระบบ AI ที่อยู่ระหว่างการพัฒนาอาจอยู่ภายใต้กระบวนการควบคุมวงจรการพัฒนาระบบ (SDLC) หรือการจัดการการเปลี่ยนแปลงที่มีอยู่แล้ว เมื่อเวลาผ่านไปและองค์กรมีการยกระดับกรณีการใช้งาน AI ที่มากขึ้น ก็จำเป็นต้องพิจารณาการควบคุมที่ใหม่กว่าหรือมีความพร้อมมากกว่าอย่างแน่นอน

ดังนั้น นโยบายและขั้นตอนการปฏิบัติงานที่ชี้แจงข้อคาดหวัง และแนวทางสำหรับบุคคลที่สามที่เกี่ยวข้องกับโครงการริเริ่มด้าน AI ก็เป็นสิ่งสำคัญเช่นกัน การประสานงานระหว่างทีมที่จัดการ AI และกลุ่มขององค์กรที่จัดการความสัมพันธ์กับบุคคลที่สาม (เช่น ฝ่ายกฎหมาย) จะส่งเสริมความสัมพันธ์กับผู้ขาย AI ที่สอดคล้องกัน เนื่องจากบุคคลที่สามเป็นส่วนเสริมของกระบวนการขององค์กร การทำความเข้าใจสภาพแวดล้อมการควบคุมของผู้ขายจึงเป็นสิ่งสำคัญยิ่ง หากมีรายงาน SOC (Service Organization Company) ของผู้ขาย AI ฝ่ายบริหารควรจัดหามาเพื่อทำความเข้าใจกระบวนการควบคุมของพวกเขา และตระหนักถึงข้อกังวลใด ๆ เช่น ข้อค้นพบจากการตรวจสอบ การใช้บุคคลที่สามที่เกี่ยวข้องกับการพัฒนาความสามารถของ AI หรือการสนับสนุนอย่างต่อเนื่องในโครงการริเริ่มด้าน AI ควรได้รับการกำหนดและติดตามอย่างชัดเจน รวมถึง SLA ที่มี “สิทธิ์ในการตรวจสอบ” ด้วย

เมื่อนโยบายและขั้นตอนการปฏิบัติงานเหล่านี้ได้รับการกำหนดแล้ว องค์กรสามารถส่งเสริมการมีส่วนร่วมของพนักงานจากหลากหลายสายงาน ด้วยการแบ่งปันเอกสารนโยบายองค์กรที่ร่างขึ้น เช่น นโยบายการใช้งานที่ยอมรับได้ไปยังพนักงานทุกคน และเปิดรับความคิดเห็นในช่วงเวลาที่กำหนด องค์กรควรวางแผนทรัพยากรที่จำเป็น สำหรับการฝึกอบรมพนักงานเกี่ยวกับนโยบายใหม่เหล่านี้ เพื่อให้แน่ใจว่าพนักงานพร้อมที่จะนำไปใช้และปฏิบัติตามบทบาท, การควบคุม และความรับผิดชอบที่กำหนดขึ้นใหม่เกี่ยวกับการใช้ AI

ในตอนต่อไป เราจะเจาะลึกถึงการบริหารจัดการความเสี่ยงด้าน AI ในระดับ First and Second Lines, การระบุความเสี่ยง และความท้าทายของ “กล่องดำ (Black Box)” ของ AI ที่เป็นเอกลักษณ์เฉพาะตัว โปรดติดตามครับ

โพสต์โดย Metha Suvanasarn

โพสต์โดย Metha Suvanasarn