สำหรับโพสต์นี้เป็นส่วนสุดท้ายหรือตอนจบของเนื้อหากรอบการทำงานการตรวจสอบปัญญาประดิษฐ์ (Artificial Intelligence Auditing Framework) ซึ่งเราจะมาเจาะลึกถึงรายละเอียดของการบริหารจัดการความเสี่ยงด้าน AI กันต่อครับ ท่านใดที่ยังไม่ได้ดูเนื้อหาก่อนหน้านี้ สามารถย้อนกลับไปดูได้ที่ กรอบการตรวจสอบ AI: การกำกับดูแลและการจัดการ (ตอนที่ 1) เพื่อความเข้าใจที่ต่อเนื่องครับ

ตอนที่ 3: กรอบการตรวจสอบ AI: การจัดการความเสี่ยงและการตรวจสอบ (ตอนที่ 2)

ทรัพยากรด้านไอทีเพื่อสนับสนุน AI

การใช้ AI จำเป็นต้องมีการเพิ่มประสิทธิภาพทรัพยากรด้านไอทีอย่างเหมาะสม ซึ่งฝ่ายบริหารควรจัดสรรงบประมาณไว้ด้วย เนื่องจาก AI ต้องการประสิทธิภาพของสินทรัพย์คอมพิวเตอร์ที่เข้มข้น เพื่อรองรับการประมวลผลที่น่าเชื่อถือ ตัวอย่างความสามารถของทรัพยากรด้านไอทีที่ใช้เพื่อสนับสนุนโครงการริเริ่มด้าน AI ขององค์กร ได้แก่:

- Central Processing Units (CPU): หรือ “สมอง” ของคอมพิวเตอร์ ทำหน้าที่ประมวลผลคำสั่งหรือคำสั่ง

- Graphics Processing Units (GPU): สมองที่มีความสามารถมากกว่า สามารถประมวลผลข้อมูลจำนวนมากพร้อมกันได้ และมีความสามารถในการคำนวณทางคณิตศาสตร์เพิ่มเติม มักใช้ในงาน AI ที่เกี่ยวกับการสร้างสรรค์ภาพ

- Storage: พื้นที่จัดเก็บข้อมูลที่ AI ต้องการสำหรับการประมวลผล โดยทั่วไปวัดเป็นเทราไบต์ (1,000 กิกะไบต์) หรือเพตาไบต์ (1,000 เทราไบต์)

- Memory (RAM): หรือหน่วยความจำเข้าถึงแบบสุ่ม เป็นพื้นที่จัดเก็บข้อมูลระยะสั้นที่เข้าถึงได้เร็วกว่า Storage ยิ่ง AI ที่ทำงานมีความซับซ้อนมากเท่าไหร่ ก็ยิ่งต้องใช้ RAM มากขึ้นเท่านั้น

- Supercomputers: คอมพิวเตอร์ที่มีการประมวลผลเร็วที่สุด ใช้สำหรับการคำนวณประสิทธิภาพสูงและมี CPU หลายตัว

- Workstations: รวมถึงคอมพิวเตอร์ตั้งโต๊ะและแล็ปท็อปที่มีข้อกำหนดทางเทคนิคที่รองรับความต้องการของ AI ที่ใช้งาน

- Software: แพลตฟอร์ม, โปรแกรม และแอปพลิเคชันที่ใช้ในการพัฒนา, นำไปใช้ และจัดการ AI ตัวอย่างเช่น Microsoft Azure AI, IBM Watsonx.ai และ Google Cloud AI Platform

- Networking Connectivity: เป็นหมวดหมู่กว้าง ๆ ที่รวมฮาร์ดแวร์, ซอฟต์แวร์ และบริการที่ช่วยให้ผู้ใช้สามารถแบ่งปันทรัพยากรดิจิทัลและแลกเปลี่ยนข้อมูลได้

แม้ผู้ตรวจสอบภายในไม่จำเป็นต้องรู้ข้อกำหนดทางเทคนิคและรายละเอียดทั้งหมดของ AI แต่ควรมีความรู้พื้นฐานเกี่ยวกับทรัพยากรด้านไอที

บุคลากรและการฝึกอบรม

การจัดบุคลากรที่เหมาะสมเป็นองค์ประกอบสำคัญของกลยุทธ์ AI ขององค์กร ฝ่ายทรัพยากรบุคคลควรทำงานร่วมกับฝ่ายบริหาร เพื่อให้แน่ใจว่ามีการสรรหาพนักงานที่มีประสบการณ์ด้าน AI ที่จำเป็นทั่วทั้งองค์กร โดยควรให้ความสำคัญกับประสบการณ์ด้าน AI ไม่เพียงแค่พนักงานที่รับผิดชอบการจัดการ AI ในแต่ละวัน แต่ยังรวมถึงผู้นำที่จะกำกับดูแลโครงการริเริ่มด้าน AI ด้วย

เนื่องจาก AI มีการพัฒนาอย่างรวดเร็ว องค์กรจึงต้องแน่ใจว่าพนักงานตระหนักถึงความก้าวหน้าและความเสี่ยงที่เกี่ยวข้อง ควรมีการฝึกอบรมสร้างความตระหนักรู้ทั่วไปเกี่ยวกับ AI ให้แก่พนักงานทุกคน และจัดโอกาสในการฝึกอบรมทางเทคนิคมากขึ้นสำหรับพนักงานที่มุ่งเน้นโครงการริเริ่มด้าน AI

การฝึกอบรมเกี่ยวกับนโยบายการใช้ AI อย่างเป็นทางการ, การรวมเรื่อง AI ไว้ในคู่มือพนักงาน และการปฐมนิเทศพนักงานใหม่ เป็นวิธีที่ดีในการเพิ่มความตระหนักรู้ขององค์กรเกี่ยวกับ AI รวมถึงความเสี่ยงที่อาจเกิดขึ้น การบูรณาการโครงการฝึกอบรมที่มุ่งเน้น AI, ความรู้ด้านดิจิทัล, นโยบายและขั้นตอนการปฏิบัติงานขององค์กร และโอกาสในการยกระดับทักษะ จะช่วยสนับสนุนโครงการริเริ่มด้าน AI ผ่านการลงทุนโดยตรงในพนักงานปัจจุบันและพนักงานใหม่ การนำไปใช้และผลลัพธ์ของโครงการริเริ่มเหล่านี้ ควรได้รับการตรวจสอบโดยการตรวจสอบภายใน ซึ่งเป็นส่วนหนึ่งของการควบคุม AI ขององค์กร

การดำเนินการ: การจัดการความเสี่ยงโดย First and Second Lines

ในตอนที่ 2 ได้กล่าวถึงความสำคัญของการระบุความเสี่ยงด้าน AI ที่เกี่ยวข้องกับความปลอดภัย, ความสมบูรณ์, ความเป็นส่วนตัว และการรักษาความลับของข้อมูล ซึ่งการจัดการข้อกังวลเหล่านี้ ควรเป็นจุดเน้นเมื่อองค์กรดำเนินโครงการ AI อัลกอริทึม AI อาศัยข้อมูลที่ถูกต้องและเชื่อถือได้ ดังนั้นทีมงานโครงการควรติดตามข้อมูลที่ป้อนเข้าอย่างใกล้ชิด องค์กรมีหลายวิธีในการตรวจสอบความครบถ้วนของข้อมูลที่ใช้ในโครงการ AI รวมถึงการตรวจสอบยอดรวมของบันทึกว่าตรงกันหรือไม่ และการวิเคราะห์รายงานข้อผิดพลาดเมื่อข้อมูลถูกโอนย้ายระหว่างระบบ ฝ่ายบริหารควรออกแบบและติดตามการควบคุมภายในที่สามารถตรวจจับความผิดปกติของคุณภาพ หรือความครบถ้วนของข้อมูลได้

ข้อพิจารณาที่สำคัญอื่น ๆ เกี่ยวกับข้อมูล ได้แก่ การจำกัดสิทธิ์การเข้าถึงเฉพาะพนักงานที่ทำงานในโครงการ AI รวมถึงสิทธิ์การเข้าถึงของผู้ดูแลระบบ การกำหนดบทบาทของผู้ใช้ และการแยกหน้าที่ (Segregation of Duties) ที่เหมาะสมก็เป็นสิ่งสำคัญเช่นกัน ตัวอย่างเช่น ผู้ดูแลระบบฐานข้อมูลที่ดูแลข้อมูลที่ป้อนเข้าไม่ควรมีสิทธิ์ในการแก้ไขอัลกอริทึมที่ประมวลผลข้อมูลนั้น ซึ่งเป็นหน้าที่ความรับผิดชอบของนักพัฒนา

เมื่อมีการนำโครงการ AI ไปใช้ สิ่งสำคัญคือ องค์กรต้องแน่ใจว่าโครงการนั้นมีความโปร่งใส, อธิบายได้, มีความรับผิดชอบ และตรวจสอบได้:

- ความโปร่งใส (Transparency): สามารถเข้าใจวัตถุประสงค์ของ AI หรืออัลกอริทึมได้ง่ายในแง่ที่เรียบง่าย

- การอธิบายได้ (Explainability): สามารถอธิบายกลไก, การคำนวณ หรือผลลัพธ์ที่ประมวลผลโดย AI หรืออัลกอริทึมได้

- ความรับผิดชอบ (Responsibility): ใช้ AI หรืออัลกอริทึมในลักษณะที่มีจริยธรรม, ปลอดภัย, เป็นธรรม และน่าเชื่อถือ

- การตรวจสอบได้ (Auditability): เมื่อแอปพลิเคชัน AI เริ่มเข้ามาแทนที่ หรือเสริมกระบวนการทางธุรกิจที่สำคัญ ควรมีการรักษาความสามารถในการตรวจสอบย้อนกลับ ผ่านบันทึกการตรวจสอบที่มีประสิทธิภาพ เนื่องจากอาจจำเป็นต้องมีการให้ความเชื่อมั่นในกระบวนการเหล่านี้

การจัดการโครงการ AI ควรระบุรายละเอียดดังต่อไปนี้สำหรับแต่ละโครงการ:

- วัตถุประสงค์, บทบาท และกำหนดเวลา: โครงการนี้มีจุดมุ่งหมายเพื่อบรรลุอะไร, ใครมีส่วนร่วม และเมื่อไหร่ที่เกิดขึ้น

- ข้อกำหนดด้านทรัพยากร: ทรัพยากรเทคโนโลยีและ/หรือบุคลากรที่จำเป็นต่อความสำเร็จ

- ข้อกำหนดด้านข้อมูล: ข้อมูลที่ป้อนเข้าที่ AI หรืออัลกอริทึมต้องการ

- ข้อกำหนดด้านความเป็นส่วนตัว, กฎหมาย และกฎระเบียบ: ข้อกำหนดในการปฏิบัติตามที่เกี่ยวข้อง

- การประเมินความเสี่ยง: ความเสี่ยงที่เกี่ยวข้องที่คุกคามการบรรลุวัตถุประสงค์ของโครงการ หรือผลลัพธ์ที่ไม่พึงประสงค์ เช่น ความลำเอียง, การปฏิบัติที่ไม่เป็นธรรม หรือการใช้ในทางที่ผิด

- ตัวชี้วัดความสำเร็จหรือ KPI: วิธีการติดตามและวัดผลความสำเร็จของโครงการ

- ข้อกำหนดในการทดสอบ: การตรวจสอบเพื่อยืนยันว่า AI หรืออัลกอริทึมทำงานตามที่ออกแบบไว้ รวมถึงการระบุและสื่อสารปัญหาที่เกิดขึ้น

การติดตามโครงการ AI อย่างต่อเนื่อง ควรดำเนินการโดยฝ่ายบริหารเพื่อให้แน่ใจว่าโครงการดำเนินไปตามแผนและเพื่อระบุปัญหาหรือข้อกังวลใด ๆ ที่เกิดขึ้น ฝ่ายบริหารมีบทบาทสำคัญในสภาพแวดล้อมการควบคุมภายใน ด้วยการจัดให้มีระดับการดำเนินการแรกเพื่อลดความเสี่ยง การติดตามในระดับโครงการมีความสำคัญ เนื่องจากเป็นจุดแรกที่สามารถตรวจพบปัญหาได้

การสนับสนุนจาก Second Line ในการบริหารความเสี่ยง

เป้าหมายหลักของกระบวนการบริหารความเสี่ยงระดับองค์กรคือ การทำความเข้าใจว่าความเสี่ยงอาจคุกคามการบรรลุวัตถุประสงค์ได้อย่างไร จากนั้นจึงดำเนินการเพื่อลดความเสี่ยงเหล่านั้น AI มักถูกพิจารณาว่าเป็นความเสี่ยงทางเทคโนโลยี แต่สิ่งสำคัญคือต้องตระหนักว่าความเสี่ยงของ AI สามารถอยู่ในหมวดหมู่ใด ๆ ก็ได้ เช่น ความเสี่ยงเชิงกลยุทธ์, การเงิน, สังคม, จริยธรรม, กฎหมาย และการกำกับดูแล

กรอบการตรวจสอบ AI ของ IIA ให้ข้อพิจารณาด้านการจัดการความเสี่ยง เพื่อสนับสนุนโครงการ AI ขององค์กรในการปฏิบัติตามแนวทางที่ดีที่สุดเกี่ยวกับ AI ซึ่งรวมถึงการพิจารณาใช้กรอบการทำงานอื่น ๆ ที่มีอยู่ เช่น NIST’s Artificial Intelligence Risk Management Framework ผู้ตรวจสอบภายในมักจะทำงานร่วมกับผู้เชี่ยวชาญด้านการบริหารความเสี่ยงในกิจกรรมต่าง ๆ เช่น กระบวนการประเมินความเสี่ยงประจำปีขององค์กร ดังนั้นจึงเป็นสิ่งสำคัญอย่างยิ่งที่ผู้ตรวจสอบภายในต้องเข้าใจความเสี่ยงที่เกี่ยวข้องกับ AI และเพิ่มฐานความรู้อย่างต่อเนื่อง

การระบุความเสี่ยง

การระบุความเสี่ยงที่เกี่ยวข้องกับ AI อาจเป็นงานใหม่สำหรับหลายองค์กร โดยในอุดมคติแล้ว การบริหารความเสี่ยงระดับองค์กร (รวมถึงการตรวจสอบภายใน, การปฏิบัติตามกฎระเบียบ และฝ่ายกฎหมาย) จะมีส่วนร่วมในการหารือเริ่มต้นของโครงการริเริ่มด้าน AI ทั้งหมด เพื่อช่วยกำหนดกรอบความเสี่ยงที่เกี่ยวข้องกับโครงการ AI

องค์กรที่มีกระบวนการประเมินความเสี่ยงทั่วทั้งองค์กรที่มั่นคงแล้ว ควรพิจารณาทำการประเมินความเสี่ยงที่มุ่งเน้น AI เป็นครั้งแรก หากไม่สามารถทำการประเมินความเสี่ยง AI แยกต่างหากได้ อย่างน้อยที่สุดองค์กรควรแน่ใจว่าได้รวม AI ไว้ในกระบวนการประเมินความเสี่ยงโดยรวม

สำหรับองค์กรที่มีกลยุทธ์ AI ที่ชัดเจน พร้อมด้วยวัตถุประสงค์และเป้าหมายที่กำหนดไว้ จะเป็นบริบทที่ฝ่ายบริหารความเสี่ยงระดับองค์กรต้องการเพื่อช่วยในการระบุความเสี่ยง AI บริบทนี้ช่วยให้ฝ่ายบริหารความเสี่ยงระดับองค์กรสามารถจัดทำรายการความเสี่ยงที่คุกคามการบรรลุวัตถุประสงค์และเป้าหมายเหล่านั้นได้ ทำให้องค์กรสามารถฝังมาตรการป้องกันอันตรายที่อาจเกิดขึ้นจากการใช้ AI ไว้ในแผนกลยุทธ์ของตนได้

อย่างไรก็ตาม สิ่งสำคัญคือต้องตระหนักว่าภูมิทัศน์ความเสี่ยงเกี่ยวกับ AI ยังคงเปลี่ยนแปลงอย่างรวดเร็ว ทำให้เกิดผลลัพธ์เชิงลบที่ไม่พึงประสงค์จากความเสี่ยงที่ไม่ได้คำนึงถึง ซึ่งอาจรวมถึง:

- ผลลัพธ์ที่มีอคติหรือเลือกปฏิบัติที่อาจส่งผลกระทบอย่างไม่เป็นธรรมต่อบางส่วนของประชากร

- การประนีประนอมความเป็นส่วนตัวหรือการรักษาความลับ

- การขาดความรับผิดชอบ

- การขาดความโปร่งใสและการอธิบายได้

- อันตรายทางการเงินหรือความเหลื่อมล้ำทางเศรษฐกิจ

- อันตรายต่อสิ่งแวดล้อม

- ข้อมูลที่ผิดหรือการบิดเบือน

- การละเมิดลิขสิทธิ์

“กล่องดำ” (The Black Box)

แม้ว่ากระบวนการระบุ, ประเมิน และลดความเสี่ยงส่วนใหญ่สำหรับโครงการ AI จะปฏิบัติตามแนวทางที่ดีที่สุดที่มีอยู่ แต่สิ่งสำคัญคือต้องทราบว่า “กล่องดำ” (Black Box) ของ AI ก่อให้เกิดความเสี่ยงที่แตกต่างกัน คำนี้หมายถึงการขาดความโปร่งใสในระบบ AI และวิธีการตัดสินใจของมัน โดยเฉพาะอย่างยิ่งในโมเดล Deep Learning ซึ่งอาจเป็นเรื่องยากที่จะทำความเข้าใจเนื่องจากการประมวลผลที่ซับซ้อนโดยอัลกอริทึม

ผู้เชี่ยวชาญด้านความเสี่ยงและผู้ตรวจสอบภายในสามารถจัดการกับ “กล่องดำ” ได้โดยตรงด้วยการ:

- ระบุและสื่อสารอย่างชัดเจนในจุดที่อาจมีข้อมูลที่ขาดหายไปหรือไม่สมบูรณ์ภายในโครงการ AI ตัวอย่างเช่น หากองค์กรใช้ผู้ขาย AI จากภายนอกที่ไม่ให้ข้อมูลโดยละเอียดเกี่ยวกับข้อมูลการฝึกอบรมอัลกอริทึม ควรบันทึกและเปิดเผยสิ่งนี้เป็นความเสี่ยงที่อาจเกิดขึ้น

- ประเมินและแจ้งให้คณะกรรมการทราบอย่างต่อเนื่องเกี่ยวกับผลกระทบที่อาจเกิดขึ้นจากช่องว่างข้อมูลที่ระบุไว้ ตัวอย่างเช่น เมื่อการขาดเอกสารของผู้ขายในชุดข้อมูลการฝึกอบรมได้รับการบันทึกแล้ว ผู้ตรวจสอบภายในควรแจ้งให้คณะกรรมการทราบเมื่อเผชิญกับผลลัพธ์ที่เกี่ยวข้องกับความเสี่ยง

- นำเสนอแนวทางในการลดความเสี่ยงที่เกี่ยวข้องกับช่องว่างความรู้ของ “กล่องดำ” ที่ได้บันทึกและประเมินไว้ก่อนหน้านี้ ตัวอย่างเช่น จากการประเมินและผลที่ตามมาที่นำเสนอ องค์กรตัดสินใจที่จะเปลี่ยนไปใช้ผู้ขาย AI รายใหม่ที่มีเอกสารข้อมูลที่โปร่งใสมากขึ้น

การประเมินความเสี่ยง

การประเมินและวิเคราะห์ความเสี่ยงที่เกี่ยวข้องกับ AI ควรเป็นไปตามกระบวนการที่คล้ายคลึงกับที่องค์กรใช้ในการทบทวนความเสี่ยงอื่น ๆ โดยควรพิจารณา ผลกระทบ (Impact) และ โอกาสที่จะเกิดขึ้น (Likelihood) ก่อน ผลกระทบของความเสี่ยงที่เกี่ยวข้องกับ AI อาจเป็นเรื่องยากที่จะวัดปริมาณได้ เนื่องจากมีข้อพิจารณามากมาย เช่น ผลกระทบทางกฎหมาย, กฎระเบียบ, สังคม, การเงิน, สิ่งแวดล้อม และจริยธรรม ความเสียหายต่อชื่อเสียงของแบรนด์ก็เป็นข้อพิจารณาสำหรับผลกระทบเช่นกัน

การรวมกันของผลกระทบและโอกาสที่จะเกิดขึ้นจะส่งผลให้เกิด ความเสี่ยงโดยธรรมชาติ (Inherent Risk) ซึ่งเป็นการวัดความเสี่ยงที่มีอยู่โดยไม่มีการพิจารณาการควบคุมภายใน หลังจากประเมินความเสี่ยงโดยธรรมชาติแล้ว ขั้นตอนต่อไปคือการกำหนด ความเสี่ยงคงเหลือ (Residual Risk) ซึ่งรวมถึงการพิจารณาว่าความเสี่ยงได้รับการบรรเทาได้ดีเพียงใด

การจัดลำดับความสำคัญของความเสี่ยง เป็นกระบวนการที่องค์กรใช้ เพื่อจัดอันดับความเสี่ยงตามลำดับความสำคัญ กล่าวคือ ความเสี่ยงที่ส่งผลกระทบมากที่สุดจะได้รับการจัดการก่อน องค์กรมีทรัพยากรที่จำกัด แต่เผชิญกับความเสี่ยงที่ไม่จำกัด ดังนั้นการจัดลำดับความสำคัญของความเสี่ยงที่เกี่ยวข้องกับ AI ภายใน กรอบการวิเคราะห์ความเสี่ยงทั่วทั้งองค์กรจึงเป็นสิ่งสำคัญ

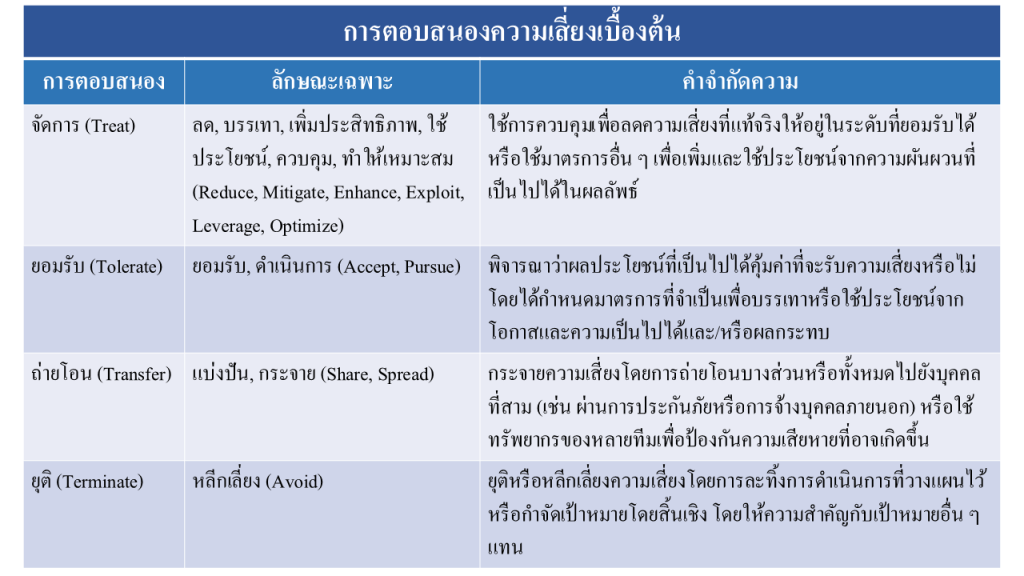

การลดความเสี่ยง

การลดความเสี่ยง (Risk Mitigation) เป็นการกระทำที่ฝ่ายบริหารดำเนินการ เพื่อลดความเสี่ยงให้อยู่ในระดับที่ยอมรับได้ ในหลายกรณี องค์กรเลือกที่จะจัดการความเสี่ยงที่เกี่ยวข้องกับ AI ด้วยการกระทำเพื่อลดความเสี่ยง เช่น การเพิ่มการควบคุมภายใน อย่างไรก็ตาม มีการตอบสนองความเสี่ยงที่เป็นไปได้อื่น ๆ อีกหลายประการ

มีหลายปัจจัยที่มีอิทธิพลต่อวิธีที่องค์กรกำหนดว่าจะตอบสนองต่อความเสี่ยงที่เกี่ยวข้องกับ AI อย่างไร ดังนั้นการมีกระบวนการตอบสนองความเสี่ยงที่กำหนดไว้และสามารถทำซ้ำได้จึงเป็นสิ่งสำคัญ ความเสี่ยงที่เกี่ยวข้องกับ AI อาจเปลี่ยนแปลงได้ในระหว่างโครงการ ดังนั้นองค์กรควรทบทวนอย่างต่อเนื่องว่าจะตอบสนองและลดความเสี่ยงอย่างไร

การตรวจสอบภายใน: กิจกรรมที่ปรึกษาและให้ความเชื่อมั่น

หลังจากที่ได้อธิบายถึงแนวทางที่องค์กรควรใช้ในการจัดการ AI ในสองส่วนแรกของกรอบการทำงานแล้ว ส่วนสุดท้ายที่เหลืออยู่คือ การตรวจสอบภายใน (Internal Audit)

สองส่วนแรกของกรอบการทำงานนี้เป็นพื้นฐานสำหรับการที่การตรวจสอบภายใน จะสามารถให้บริการทั้งด้านการให้คำปรึกษาและการตรวจสอบแก่องค์กรได้ ส่วน การกำกับดูแล (Governance) และ การจัดการ (Management) มีรายละเอียดที่ผู้ตรวจสอบภายใน ควรนำไปใช้ในการแนะนำองค์กรให้ปรับปรุงแนวทางปฏิบัติ หรือใช้เป็นพื้นฐานในการประเมินว่าองค์กรกำลังเข้าถึง, ใช้, จัดการ และติดตาม AI อย่างไร

คำว่า “ความเชื่อมั่นที่สมเหตุสมผล” (Reasonable Assurance) มักถูกอ้างถึงในวิชาชีพการตรวจสอบภายใน จากมุมมองของการควบคุมภายใน ความเชื่อมั่นที่สมเหตุสมผลหมายถึงมีความเป็นไปได้สูงที่การควบคุมจะสามารถลดความเสี่ยงได้ แต่ก็ไม่ถึงกับเป็นความแน่นอนแบบสมบูรณ์ (absolute) หลักการเดียวกันนี้ควรถูกนำมาพิจารณาสำหรับผู้ตรวจสอบภายในที่ได้รับมอบหมายให้ทำหน้าที่ให้ความเชื่อมั่นเกี่ยวกับ AI

ความท้าทาย

หลายแง่มุมของ AI ทำให้กิจกรรมการให้ความเชื่อมั่นเป็นเรื่องยากสำหรับผู้ตรวจสอบภายใน ซึ่งรวมถึง:

- ความซับซ้อนโดยธรรมชาติ: AI (หรือเฉพาะเจาะจงลงไปคืออัลกอริทึม) มีความซับซ้อนสูง ซึ่งเป็นปัญหา “กล่องดำ (Black Box)” ที่ยากขึ้นไปอีก

- การเพิ่มขึ้นอย่างรวดเร็วของความสามารถและความเสี่ยง: ความสามารถและความเสี่ยงของ AI เพิ่มจำนวนขึ้นอย่างรวดเร็ว

- การขาดเครื่องมือและแนวทางที่ยอมรับกันอย่างกว้างขวาง: AI ยังเป็นหัวข้อการตรวจสอบที่กำลังพัฒนา และมีเครื่องมือหรือแนวทางที่ใช้กันอย่างแพร่หลายอย่างจำกัด

- โอกาสในการฝึกอบรมที่มีจำกัด: โอกาสในการฝึกอบรมเพื่อเพิ่มพูนทักษะการตรวจสอบ AI ยังมีอยู่อย่างจำกัด

AI ในฐานะหัวข้อการตรวจสอบอาจดูน่าหนักใจ แต่การมุ่งเน้นไปที่ข้อพิจารณาต่อไปนี้ จะช่วยให้ผู้ตรวจสอบภายในมีทัศนคติเชิงบวกและมีความมั่นใจ:

- ไม่คาดหวังว่าจะเป็นผู้เชี่ยวชาญ: ผู้ตรวจสอบภายในไม่จำเป็นต้องเป็นผู้เชี่ยวชาญในทุกหัวข้อการตรวจสอบ แต่ควรมีแนวทางที่เป็นระบบ, มีระเบียบวินัย และมุ่งเน้นการคิดเชิงวิพากษ์ และการระบุความเสี่ยงเป็นวัตถุประสงค์หลักสำหรับทุกการตรวจสอบ ไม่ใช่แค่ AI การมีความคุ้นเคยและความรู้ในเชิงปฏิบัติเกี่ยวกับ AI เป็นสิ่งสำคัญอย่างยิ่ง แต่การรู้ในทุกแง่มุมทางเทคนิคของ AI อาจไม่ใช่เรื่องที่จำเป็น และอาจต้องอาศัยผู้เชี่ยวชาญทางเทคนิคจากภายนอกมาช่วยในแง่มุมที่ซับซ้อนมากขึ้น เช่น การแกะรหัสอัลกอริทึม

- มองการตรวจสอบ AI เป็นความก้าวหน้า ไม่ใช่จุดหมายปลายทาง: เนื่องจาก AI มีความซับซ้อนและเปลี่ยนแปลงอย่างรวดเร็ว จึงไม่น่าเป็นไปได้ที่ผู้ตรวจสอบภายในจะมีความรู้ในเรื่องนี้อย่างสมบูรณ์แบบ ดังนั้นควรเพิ่มพูนความเข้าใจเกี่ยวกับ AI เมื่อเวลาผ่านไป

- กล้าที่จะถามคำถามที่เกี่ยวข้องเกี่ยวกับ AI ภายในองค์กร:

- AI ช่วยให้องค์กรบรรลุเป้าหมายเชิงกลยุทธ์ได้อย่างไร?

- มีความเสี่ยงอะไรที่เกี่ยวข้องและเรากำลังลดความเสี่ยงเหล่านั้นอย่างไร?

- มีการควบคุมภายในที่เพียงพอสำหรับกระบวนการที่เกี่ยวข้องกับ AI หรือไม่?

- ข้อมูลที่ใช้สำหรับ AI มีความครบถ้วน, แม่นยำ และเชื่อถือได้หรือไม่?

- มีการทดสอบ AI ก่อนนำไปใช้งานอย่างไรเพื่อให้แน่ใจว่าไม่มีความลำเอียง?

- มีการทดสอบ AI หลังการใช้งานอย่างไรเพื่อให้แน่ใจว่าไม่มีความลำเอียง?

- มีการกำกับดูแล AI อย่างไร?

- องค์กรรับประกันได้อย่างไรว่า มีการฝึกอบรมและสร้างความตระหนักรู้ด้าน AI ที่เพียงพอ?

ดังที่ได้อธิบายไว้ในตอนที่ 2 การทำความเข้าใจการใช้งาน AI ขององค์กรเริ่มต้นจากการค้นคว้าและพูดคุย สิ่งสำคัญคือผู้ตรวจสอบภายในต้องใช้ประโยชน์จากความสัมพันธ์ทางวิชาชีพที่ได้สร้างไว้ การมีความโปร่งใสกับทั้งฝ่ายบริหารและคณะกรรมการกำกับดูแลเป็นสิ่งสำคัญ ควรใช้ภาษาที่เรียบง่ายเพื่ออธิบายว่าเราคิดอย่างไรเกี่ยวกับหัวข้อ AI และวางแผนที่จะมีส่วนร่วมกับองค์กรอย่างไรเพื่อเรียนรู้เพิ่มเติม

การตรวจสอบ AI ถือเป็นความรับผิดชอบที่ค่อนข้างใหม่สำหรับหลายองค์กร ในฐานะผู้ให้ความเชื่อมั่น ผู้ตรวจสอบภายในไม่จำเป็นต้องเป็นผู้เชี่ยวชาญในหัวข้อ AI แต่ต้องระบุโอกาสในการเพิ่มพูนความรู้และความตระหนักในเรื่องนี้ การทำความเข้าใจแง่มุมทางเทคนิคของ AI ให้ดียิ่งขึ้น เช่น อัลกอริทึม จะมีความสำคัญต่อการพัฒนาวิชาชีพในอนาคต

แม้ว่า AI จะมีองค์ประกอบที่ซับซ้อน แต่สิ่งสำคัญคือต้องจำไว้ว่ามันสร้างผลลัพธ์บางอย่างจากข้อมูลที่ได้รับ ในมุมมองของการให้ความเชื่อมั่น ผู้ตรวจสอบภายในอาจไม่เคยมีความรู้ที่สมบูรณ์แบบเกี่ยวกับกลไกภายในทั้งหมดของ AI แต่การช่วยองค์กร 1) ประเมินสิ่งที่พวกเขากำลังทำเพื่อให้แน่ใจว่าข้อมูลที่ป้อนเข้ามีความแม่นยำที่สุดเท่าที่จะเป็นไปได้ และ 2) ทำความเข้าใจวิธีการตรวจสอบผลลัพธ์นั้น ควรเป็นวัตถุประสงค์หลักของผู้ปฏิบัติงาน ผู้ตรวจสอบภายในนำแนวคิดเหล่านี้มาใช้ในปัจจุบันเมื่อทำการตรวจสอบระบบไอทีของแอปพลิเคชันทางธุรกิจ และหัวใจสำคัญร่วมกันคือแนวคิดเรื่อง “การตรวจสอบย้อนกลับ (Traceability)” ซึ่งหมายถึงการทำให้แน่ใจว่าข้อมูลและผลลัพธ์สอดคล้องกับวัตถุประสงค์ทางธุรกิจและข้อกำหนดของกรณีการใช้งาน AI นั้น ๆ

โดยสรุปแล้ว การตรวจสอบ AI ไม่ใช่เรื่องที่เป็นไปไม่ได้ แต่เป็นวิวัฒนาการที่ต้องอาศัยการปรับตัวของผู้ตรวจสอบภายใน ด้วยกรอบการทำงานนี้ ผู้ตรวจสอบภายในสามารถเริ่มต้นการเดินทาง เพื่อเป็นส่วนสำคัญในการสร้างความเชื่อมั่นให้กับองค์กร ในยุคที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ได้อย่างมั่นคงและมีประสิทธิภาพ

โพสต์โดย Metha Suvanasarn

โพสต์โดย Metha Suvanasarn