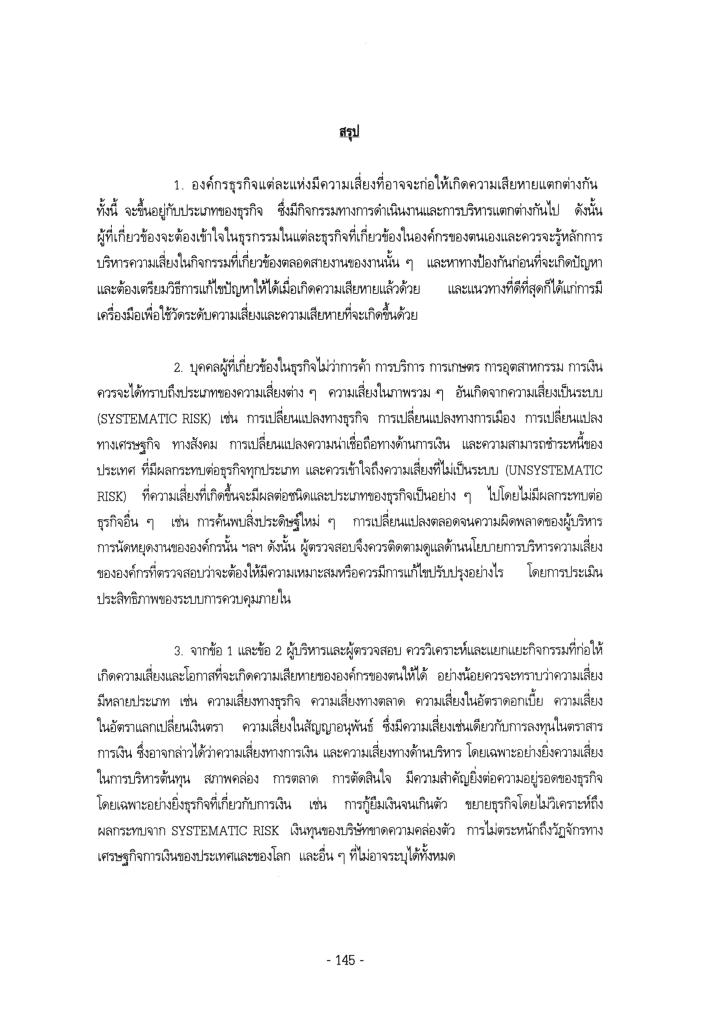

ในยุคที่ภัยคุกคามทางไซเบอร์กลายเป็นความเสี่ยงระดับชาติ การรับมือเชิงรับเพียงอย่างเดียวไม่เพียงพออีกต่อไป โดยเฉพาะสำหรับองค์กรภาครัฐและรัฐวิสาหกิจ ซึ่งมีบทบาทสำคัญต่อโครงสร้างพื้นฐานและการให้บริการสาธารณะ สำหรับโพสต์นี้ ผมจึงชวนผู้อ่านมาทำความเข้าใจแนวทางการพัฒนาเชิงรุก (Proactive Development) เพื่อสร้างความสามารถในการฟื้นตัวและยืนหยัด (Cyber Resilience) ให้กับรัฐวิสาหกิจ โดยอิงจากกรอบแนวคิดและ/หรือมาตรฐานต่าง ๆ เพื่อเชื่อมโยง Cybersecurity เข้ากับการบริหารยุทธศาสตร์องค์กรอย่างเป็นระบบ

เชื่อม Cybersecurity กับยุทธศาสตร์องค์กร: เริ่มต้นที่วิสัยทัศน์

Cybersecurity ไม่ใช่เรื่องของฝ่าย IT เท่านั้น แต่ควรเป็นส่วนหนึ่งของกลยุทธ์องค์กรอย่างแท้จริง จุดเริ่มต้นของความมั่นคงที่ยั่งยืน คือการออกแบบ Cybersecurity Strategy ให้สนับสนุนวิสัยทัศน์ พันธกิจ และวัตถุประสงค์ขององค์กรได้อย่างชัดเจน ซึ่งควรถูกฝังอยู่ในแผนยุทธศาสตร์ เช่น Enterprise Risk Management, KPI ระดับองค์กร หรือแผนพัฒนาทรัพยากรบุคคล การมีวิสัยทัศน์ที่เชื่อมโยง Cybersecurity กับเป้าหมายองค์กร จึงเป็นรากฐานของ Resilience ที่แท้จริง

กรอบมาตรฐานช่วยให้มีกลยุทธ์ที่เป็นรูปธรรม

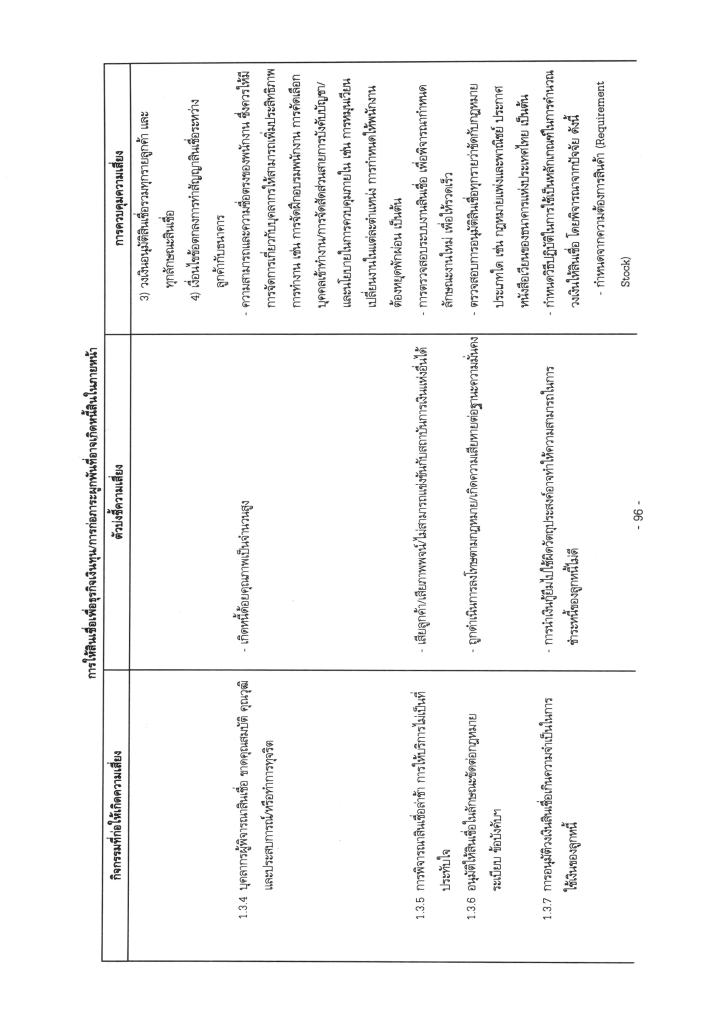

การเลือกกรอบมาตรฐานที่เหมาะสมเป็นหัวใจในการยกระดับการบริหารด้านไซเบอร์ โดยมีกรอบที่ได้รับการยอมรับอย่างแพร่หลาย เช่น:

- NIST Cybersecurity Framework (CSF): โดดเด่นในการเชื่อมความเสี่ยงไซเบอร์กับเป้าหมายเชิงกลยุทธ์ ผ่าน 5 ฟังก์ชันหลัก: Identify, Protect, Detect, Respond, และ Recover

- COBIT: เน้น Governance และการจัดการที่เชื่อมโยงกับกลยุทธ์องค์กรได้ชัดเจน โดยเฉพาะในการบริหาร IT อย่างมีระบบ

- ISO/IEC 27001 และ 27002: เหมาะสำหรับการจัดการความมั่นคงสารสนเทศเป็นระบบ มีบริบทที่เชื่อมโยงกับองค์กรและเป้าหมายทางธุรกิจ

- SE-AM: เป็นกรอบที่พัฒนาโดยหน่วยงานภาครัฐไทย (สรอ.) เมื่อปรับปรุงเรื่อง Cybersecurity Framework แล้วจะช่วยให้องค์กรภาครัฐและรัฐวิสาหกิจสามารถกำหนดแนวทางเชิงยุทธศาสตร์ด้านไซเบอร์ให้สอดคล้องกับ Governance และ PDPA (Personal Data Protection Act)/GDPR (General Data Protection Regulation) ได้ง่าย

SE-AM: ทางเลือกเชิงยุทธศาสตร์ของรัฐวิสาหกิจไทย

สำหรับรัฐวิสาหกิจไทย กรอบ SE-AM ถือว่าเหมาะสม เพราะออกแบบมาโดยเฉพาะสำหรับบริบทองค์กรภาครัฐ มีจุดแข็งที่สำคัญคือ การเน้นการขับเคลื่อนจากบนลงล่าง (Top-down) ซึ่งสอดคล้องกับโครงสร้างการบริหารภาครัฐ และสามารถผสานเข้ากับกรอบสากลอื่นได้ เช่น นำ NIST CSF มาใช้เป็น baseline และค่อยต่อยอดไปยัง ISO 27001 ตามลำดับความพร้อม

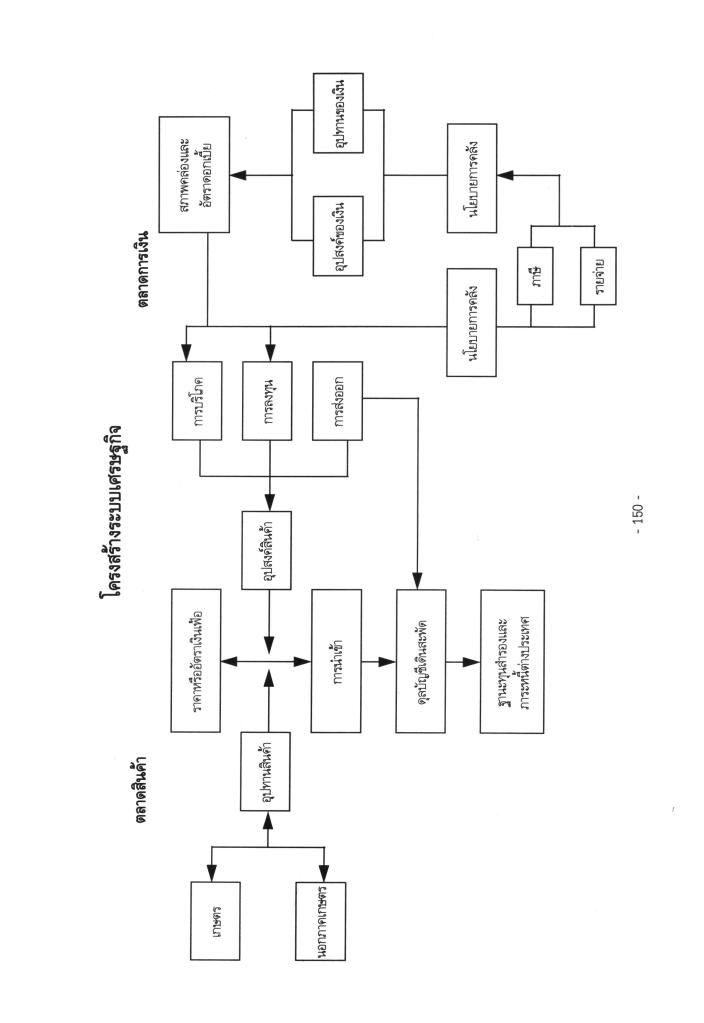

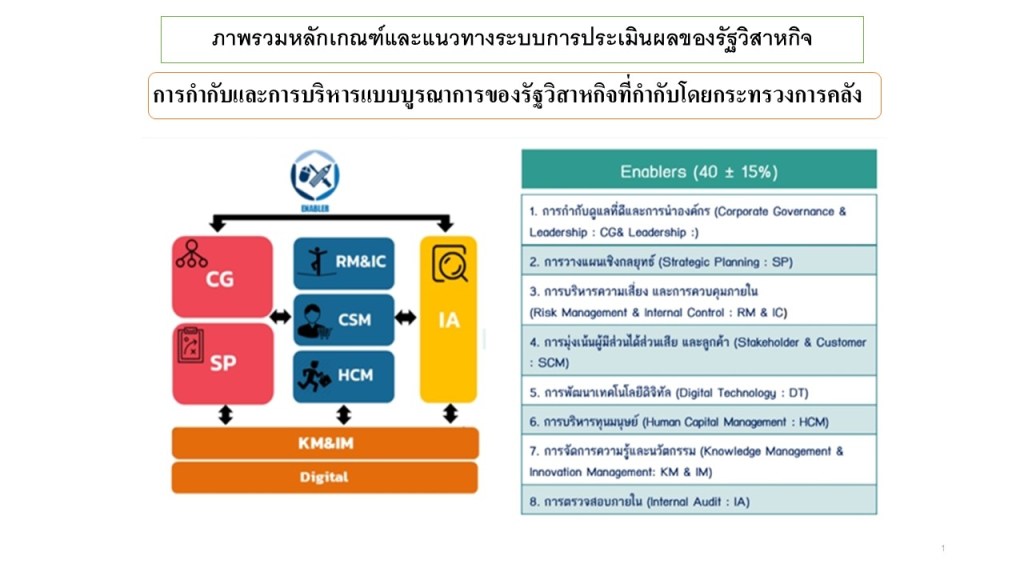

อย่างไรก็ดี Core Business Enablers ในการที่หน่วยงานกำกับใช้เป็นกรอบในการประเมินผลการดำเนินงานรัฐวิสาหกิจนั้น ยังไม่ได้รวมมาตรฐานที่เกี่ยวข้องกับการปฏิบัติตามกฎหมาย กฎเกณฑ์ ทั้งภายในประเทศและภายนอกประเทศ ที่มีผลอย่างสำคัญยิ่งต่อรัฐวิสาหกิจที่ควรจะปฏิบัติตาม หลักการ Governance และ Management ที่มีผลไปถึง Performance และ Conformance ของรัฐวิสาหกิจ ที่มีผลสะท้อนไปยังยุทธศาสตร์ชาติ นโยบายรัฐบาล และแผนยุทธศาสตร์ของรัฐวิสาหกิจ ฯลฯ

นอกจากนี้ จะส่งผลกระทบต่อผลการดำเนินงานที่สำคัญ (Key Results) ต่อผลการดำเนินงานตามภารกิจที่สำคัญที่เกี่ยวข้องกับแผนงาน โครงการ ที่สะท้อนประสิทธิภาพ ประสิทธิผล ผลสัมฤทธิ์ ฯลฯ ในแต่ละ Core Business Enablers รวมทั้งการบูรณาการ ในการประเมินประสิทธิภาพ และประสิทธิผล ต่อ Core Business Enablers โดยรวม โดยเฉพาะอย่างยิ่ง ในเรื่องที่เกี่ยวข้องกับการพัฒนาในเชิงรุกเพื่อให้เกิด Resilience ทางด้าน Cybersecurity ฯลฯ ของรัฐวิสาหกิจที่เกี่ยวข้องกับการปฏิบัติตามกฎหมาย กฎเกณฑ์ ตามมาตรฐานและ Best Practice ที่เกี่ยวข้อง ซึ่งมีผลกระทบอย่างสำคัญต่อ GRC และ ESG และ output, outcome ต่อ performance และ conformance รวมทั้ง กระบวนการสร้างคุณค่าเพิ่ม (Value Creation) ในลักษณะ End-to-End ของรัฐวิสาหกิจ/องค์กร และกรอบมาตรฐาน ที่ช่วยให้องค์กรมีกลยุทธ์ที่เป็นรูปธรรม ตามที่ได้กล่าวข้างต้น

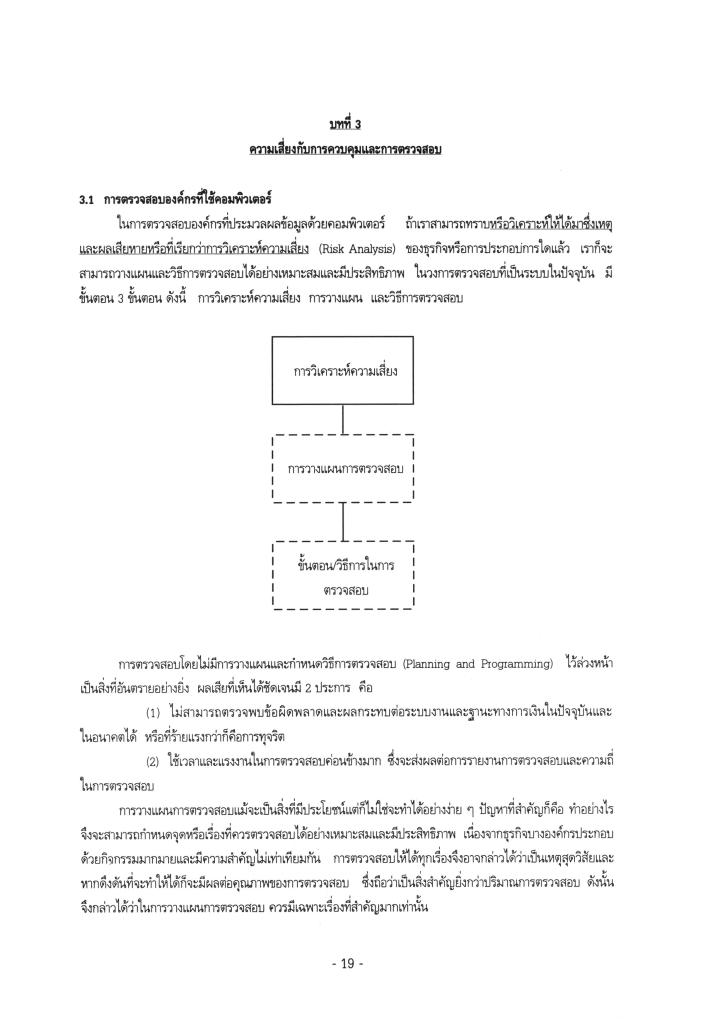

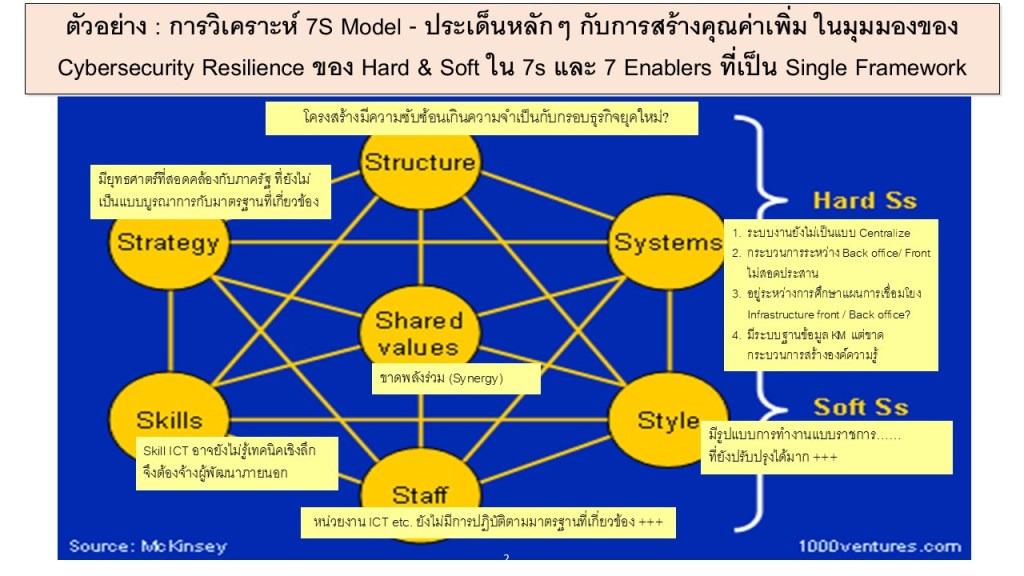

ภาพรวม: ใช้ 7S Model เป็นเลนส์ในการพัฒนา Cybersecurity Resilience

Cybersecurity ไม่ใช่เรื่องเทคนิคเท่านั้น แต่ต้อง “ฝังอยู่ในระบบคุณค่า” และ “ถูกขับเคลื่อนร่วมกัน” โดยทุกส่วนงานขององค์กร ดังที่ McKinsey 7S Model แสดงไว้ แบ่งเป็น:

- Hard S (Strategy, Structure, Systems) – สิ่งที่จัดการได้ชัดเจน

- Soft S (Shared Values, Skills, Staff, Style) – สิ่งที่ฝังลึกในวัฒนธรรมองค์กร

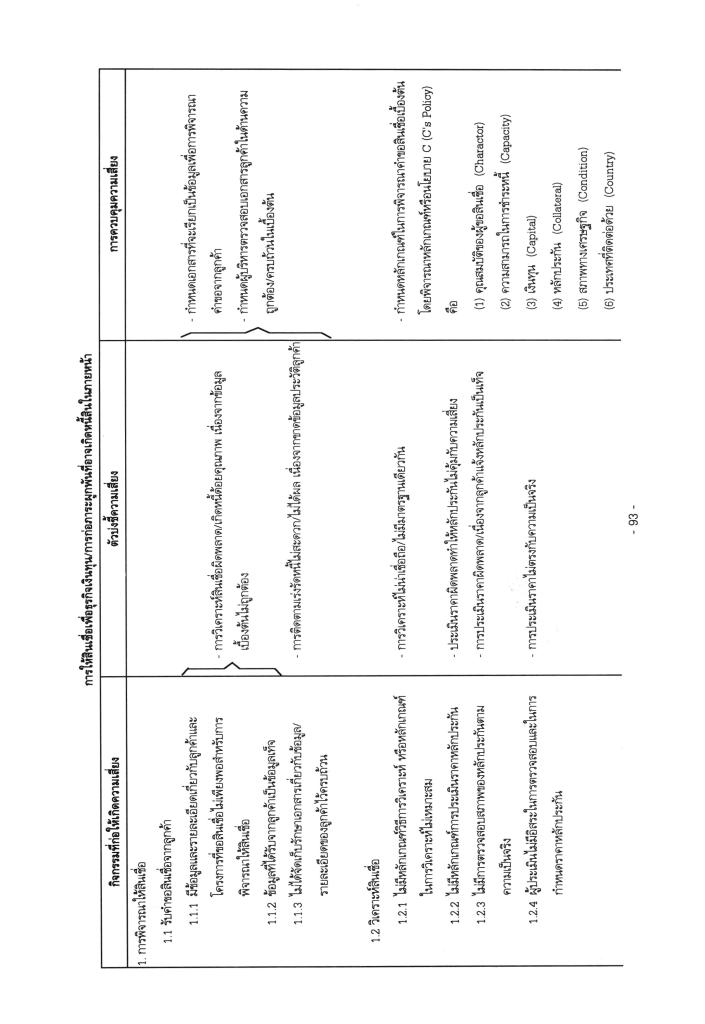

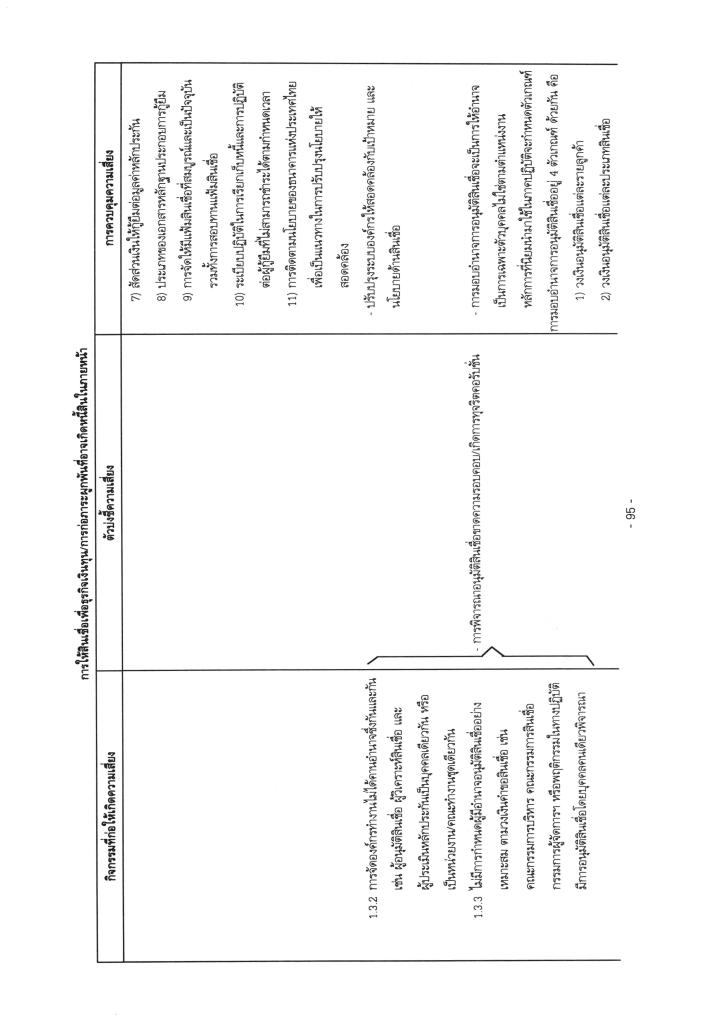

แนวทางบูรณาการที่ครอบคลุมเพื่อ Resilience ด้านไซเบอร์:

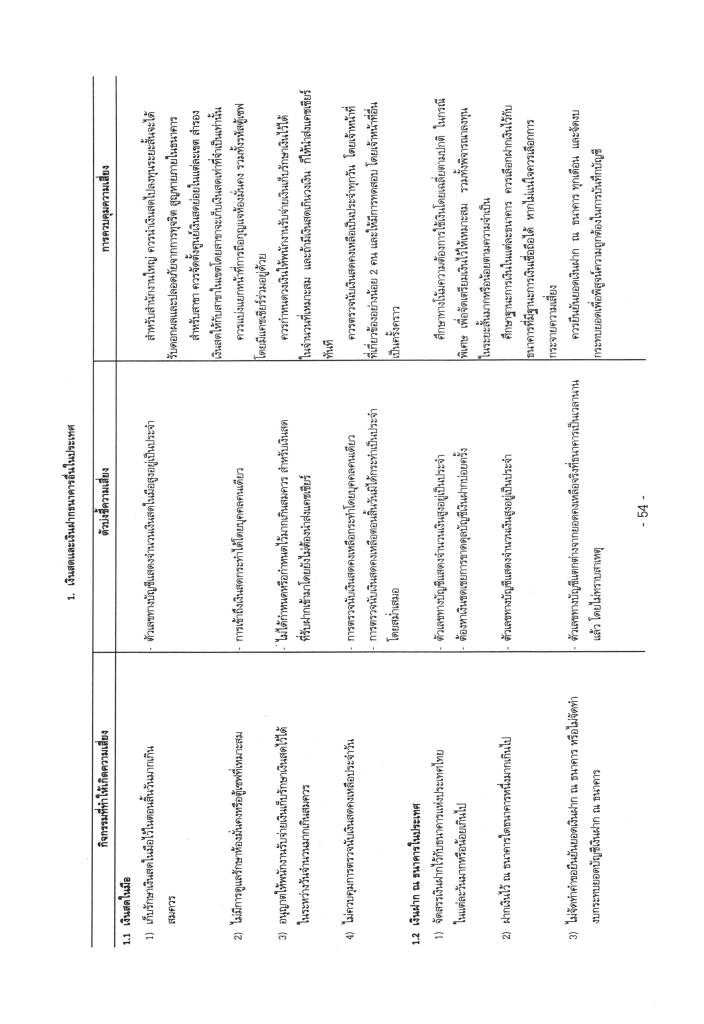

1. Strategy:

จุดเสี่ยง: ยุทธศาสตร์ที่ยังไม่เชื่อมโยงกับภาครัฐและไม่ตอบโจทย์การเปลี่ยนผ่านสู่ดิจิทัล (Thailand 4.0) และอาจยังไม่เชื่อมโยงกับแนวทางการพัฒนาสู่ AI Transformation ซึ่งจะมีผลกระทบอย่างสำคัญต่อกระบวนการ Governance และ Management ที่สำคัญของทุกองค์กร

แนวทาง:

- ต้องกำหนด Cybersecurity Strategy ให้สอดคล้องกับ Vision และ Strategic Plan ระดับองค์กร

- เสนอให้รวมไซเบอร์เข้าใน KPI ยุทธศาสตร์, แผนบริหารความเสี่ยงองค์กร และ SE-AM Framework

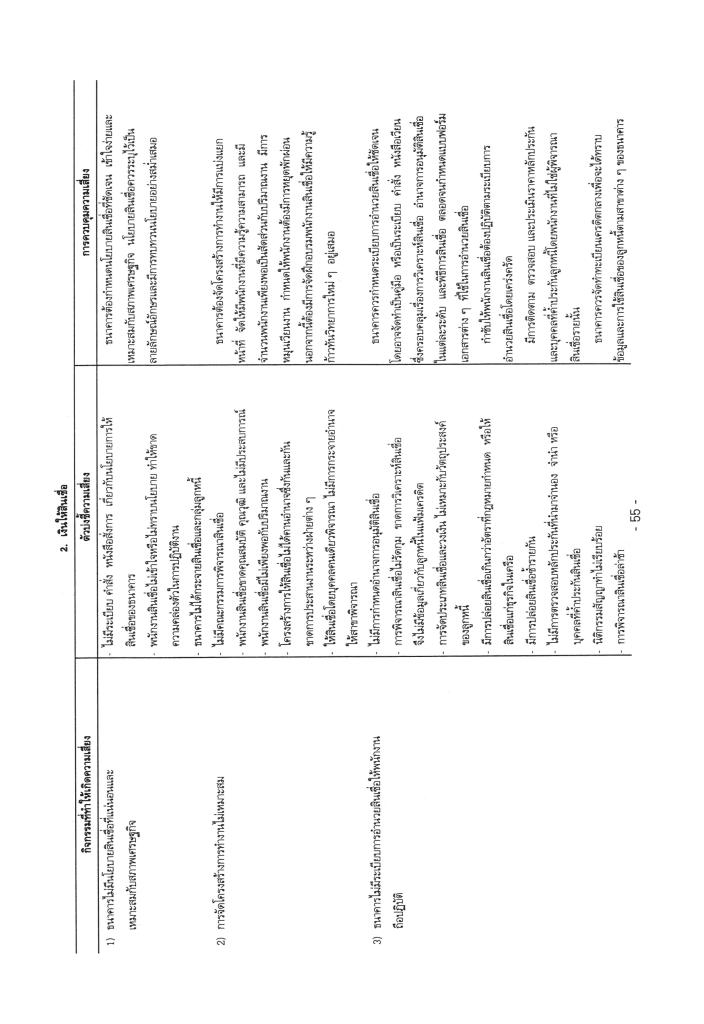

2. Structure:

จุดเสี่ยง: โครงสร้างยังมีความซับซ้อน และขาดความคล่องตัว

แนวทาง:

- ปรับโครงสร้างให้เกิด Cyber Governance Board หรือ CISO ที่รายงานต่อผู้บริหารโดยตรง

- ส่งเสริมโครงสร้างที่เอื้อต่อ cross-functional team ในการบริหารเหตุการณ์ไซเบอร์

3. Systems:

จุดเสี่ยง: ขาดระบบ Centralized, Back/Front office ไม่สอดประสาน, KM ยังไม่ครบ

แนวทาง:

- พัฒนา Cybersecurity Architecture แบบ Zero Trust

- ใช้ระบบ Cyber KM และ Threat Intelligence เป็นระบบประสานร่วม

- เชื่อมโยงกับ GRC Tools และ PDPA Compliance Platform

4. Shared Values:

จุดเสี่ยง: ขาดพลังร่วม (Synergy) ในการขับเคลื่อนเป้าหมายองค์กร

แนวทาง:

- วาง “Cybersecurity เป็นวาระองค์กร”

- สื่อสารคุณค่าเรื่อง “Trust, Integrity, และ Resilience” ผ่าน Internal Branding

- จัดกิจกรรมสร้างวัฒนธรรมไซเบอร์ เช่น Cyber Month หรือ Cyber Ambassadors

5. Staff:

จุดเสี่ยง: หน่วย ICT ยังไม่ทำงานตามมาตรฐาน และไม่มีบทบาทเชิงรุก

แนวทาง:

- ต้องสร้างแผนพัฒนากำลังคนไซเบอร์แบบ Multi-level (ทั้งผู้บริหาร, ผู้ปฏิบัติ, และผู้เชี่ยวชาญ)

- กำหนด JD ด้าน Cybersecurity ให้ชัดเจน และเสริมทักษะให้กับ non-IT units

6. Skills:

จุดเสี่ยง: ขาดทักษะ ICT เชิงลึก ต้องจ้างภายนอก

แนวทาง:

- อบรม Reskill & Upskill ด้าน Cybersecurity ตาม framework เช่น NICE Framework

- ใช้ internal sandbox ในการฝึกซ้อม/เรียนรู้ เช่น CTF, War Room, Incident Drill

7. Style:

จุดเสี่ยง: การบริหารยังเป็นแบบราชการ ไม่คล่องตัว

แนวทาง:

- ต้องปรับ Style การบริหารเป็น Agile + Risk-informed + Evidence-based

- ผู้นำองค์กรต้องแสดง Tone at the Top ด้าน Cybersecurity อย่างจริงจัง

“หาก Cybersecurity คือเส้นเลือดของความมั่นคงในยุคดิจิทัล… Enablers ทั้ง 7S ก็คือโครงสร้างร่างกายของรัฐวิสาหกิจ”

การประเมินผลองค์กรจึงควรใช้ 7S เป็นกรอบการพัฒนาแบบองค์รวม โดยเฉพาะเมื่อนำไปเชื่อมโยงกับโมเดล SE-AM / GRC / Performance Evaluation เพื่อให้เกิด Cybersecurity Resilience ที่ไม่เพียงแค่ป้องกันได้ แต่ฟื้นตัวและเติบโตต่อได้

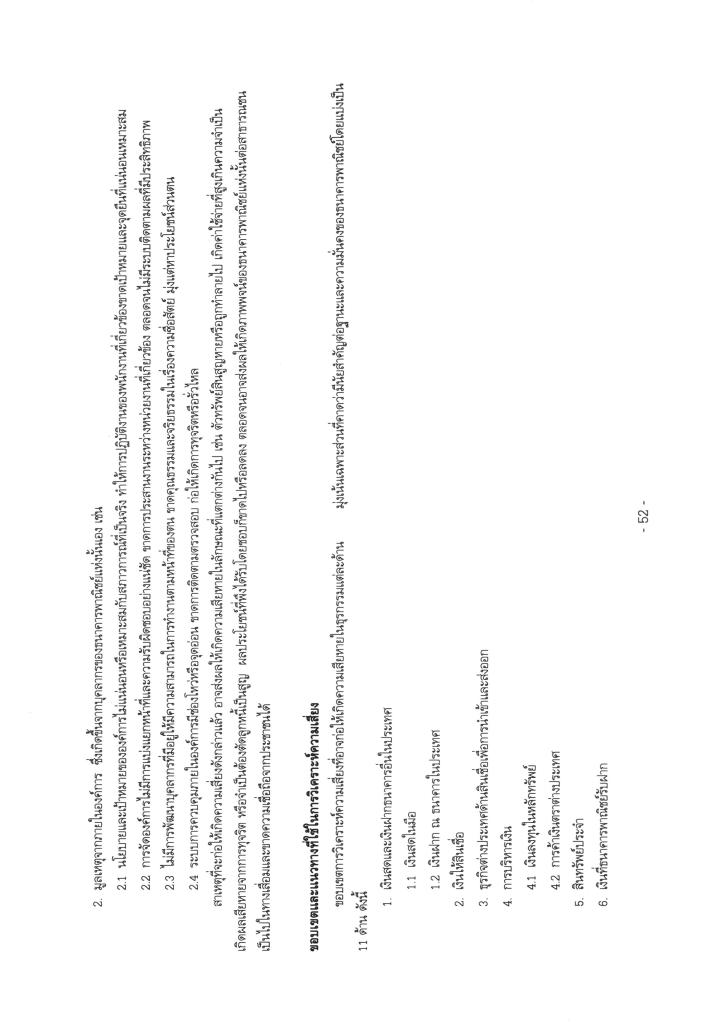

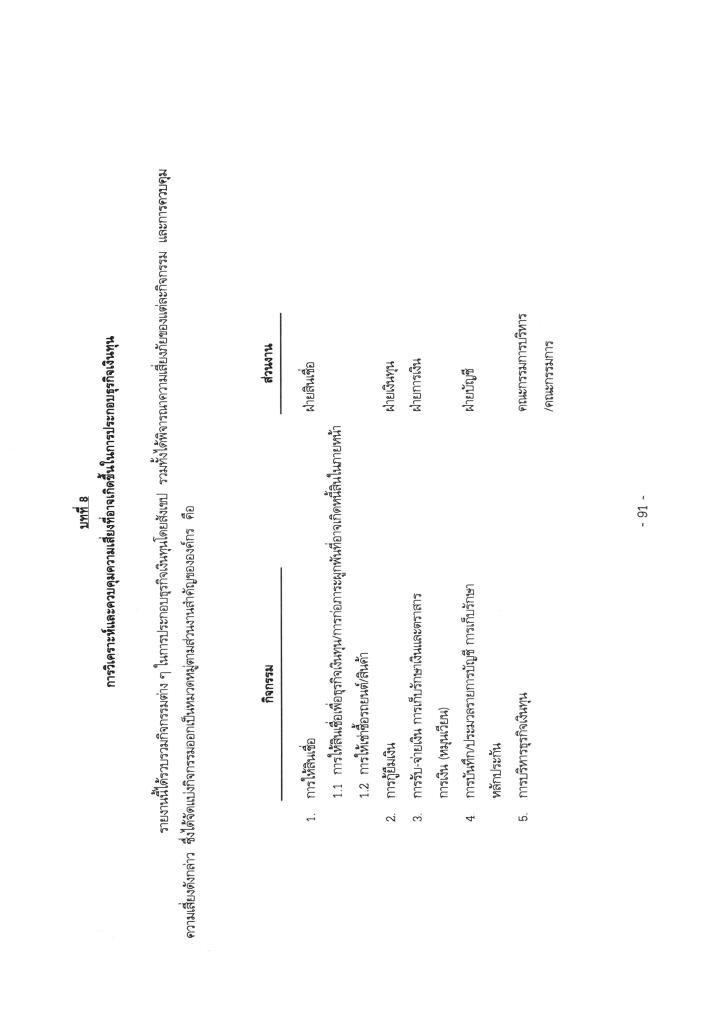

การบูรณาการไซเบอร์กับกระบวนการบริหารในทุกมิติ

Resilience ทางด้าน Cybersecurity จะเกิดขึ้นได้จริงก็ต่อเมื่อการบริหารจัดการไซเบอร์ไม่ถูกแยกออกจากกระบวนการบริหารหลักขององค์กร แต่ถูก “ฝังตัว” อยู่ในกระบวนการต่าง ๆ เช่น การจัดซื้อจัดจ้าง (procurement), การบริหารบุคลากร (HR), การเงินการบัญชี ฯลฯ และมีโครงการหรือแผนงานที่สอดคล้องกับเป้าหมายเชิงกลยุทธ์ เช่น การฝึกอบรมพนักงาน การทดสอบแผนตอบสนองเหตุการณ์ (incident response) หรือการนำระบบ automation เข้ามาช่วยลดความเสี่ยง

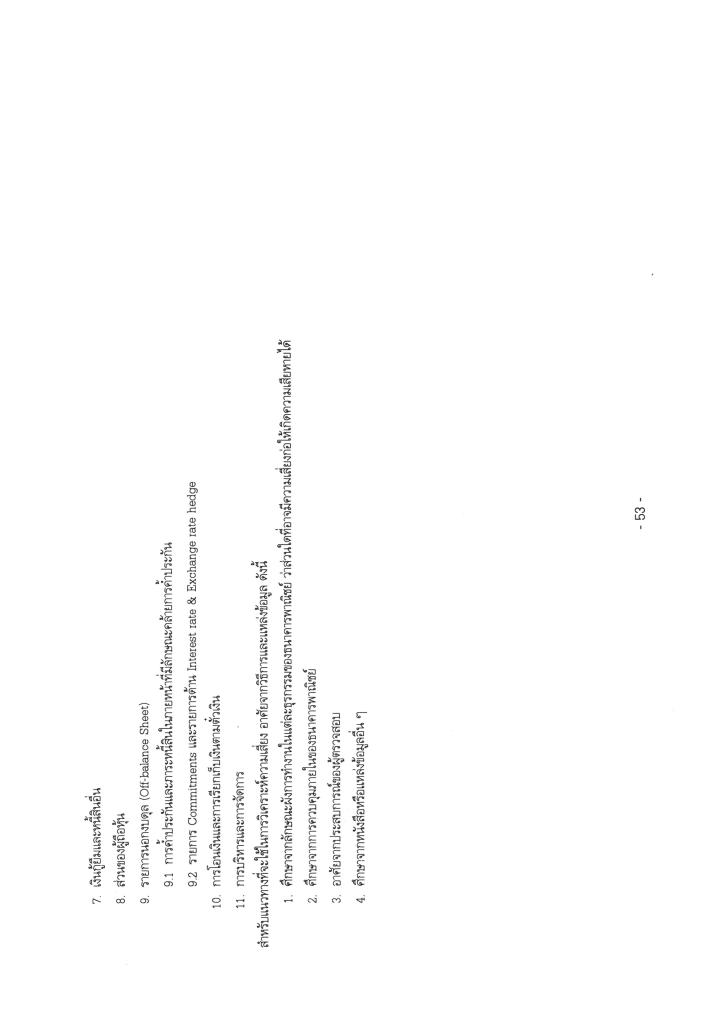

มาตรฐานไม่ได้มีไว้ให้เลือกเพียงหนึ่ง แต่ต้องผสานอย่างมียุทธศาสตร์

การเลือกใช้มาตรฐานควรคำนึงถึงความเหมาะสมกับบริบทขององค์กร ไม่จำเป็นต้องเลือกเพียงหนึ่ง แต่สามารถผสานกันได้ เช่น:

- เริ่มต้นจาก NIST CSF เพื่อความเข้าใจง่ายและเป็น baseline ที่ดี

- ใช้ COBIT สำหรับการจัดการ Governance และการกำหนดทิศทางเชิงกลยุทธ์

- นำ ISO 27002 มาใช้เฉพาะด้านการควบคุมภายในเพื่อไม่ให้ภาระมากเกินไปในช่วงเริ่มต้น

การแยกแยะระหว่าง Governance และ Management ช่วยให้องค์กรวางแผนได้ถูกจุด

ความเข้าใจเรื่อง Governance กับ Management ช่วยให้องค์กรออกแบบบทบาทและหน้าที่ได้เหมาะสม:

- Governance: มองระดับภาพรวม เช่น การกำหนดนโยบาย วิสัยทัศน์ และ oversight โดยคณะกรรมการ

- Management: มองระดับปฏิบัติ เช่น การจัดการ user, patching, หรือ incident response โดยผู้บริหาร

บทบาทของผู้บริหารในแต่ละระดับ: ร่วมขับเคลื่อน Cyber Resilience

การพัฒนา Cybersecurity ที่ยั่งยืน จำเป็นต้องมีการมีส่วนร่วมในทุกระดับ:

- Board of Directors: กำหนดทิศทาง และสร้าง “Tone at the Top”

- C-Level (CEO, CIO, CISO): วางกลยุทธ์ จัดสรรทรัพยากร สร้างความร่วมมือ และวัดผลความเสี่ยง

- ผู้บริหารระดับกลาง/ต้น: ดำเนินการ ประสานงาน และสนับสนุนบุคลากรในหน้างาน

การกำหนดบทบาทที่ชัดเจนเหล่านี้ช่วยให้ทุกคนในองค์กรรู้ว่า “Cybersecurity ไม่ใช่หน้าที่ของใครคนหนึ่ง แต่คือความรับผิดชอบร่วมกัน”

จาก SILO สู่ระบบ – เปลี่ยนความมั่นคงไซเบอร์เป็นวัฒนธรรมองค์กร

Cybersecurity ที่มี Resilience ไม่ได้เกิดขึ้นจากการออกนโยบาย หรือการใช้เครื่องมือที่ล้ำหน้าเพียงอย่างเดียว แต่เกิดจากการเข้าใจ เชื่อมโยง และมีส่วนร่วมของทุกคนในองค์กร รัฐวิสาหกิจ สามารถใช้โอกาสนี้เปลี่ยน “ไซโล” ทางไซเบอร์ให้กลายเป็นระบบที่เชื่อมโยงกับยุทธศาสตร์องค์กร สร้างวัฒนธรรมความมั่นคงที่ยั่งยืน และพร้อมรับมือกับภัยคุกคามในอนาคตอย่างมั่นใจ

การประเมินผลการดำเนินงานรัฐวิสาหกิจควรมีการปรับปรุงโดยผู้กำกับให้รัฐวิสาหกิจมีกรอบและแนวการปฏิบัติที่เหมาะสมกับการเปลี่ยนแปลงของ Digital Transformation ไปสู่ Gen-AI Transformation จึงไม่ใช่แค่แนวคิด แต่คือพลังในการขับเคลื่อนองค์กรให้มีชีวิต มีเป้าหมาย และมีภูมิคุ้มกันทางไซเบอร์ที่แข็งแกร่งในทุกระดับของการบริหารในยุคปัจจุบันและอนาคต

โพสต์โดย Metha Suvanasarn

โพสต์โดย Metha Suvanasarn